Hyper-convergence : les nouveaux challenges de la virtualisation

On parle depuis peu dans le monde des datacenters d’hyperconvergence. Il s’agit tout simplement de réduire au possible les dépendances matérielles, de stockage et de virtualisation à un ensemble qui soit totalement en cohésion, avec un minimum d’espace occupé. Voyons de façon concrète quels sont les enjeux et les acteurs de ce changement dans le monde des infrastructures IT.

Hyperconvergence : kesako ?

Petit résumé en vidéo (en français):

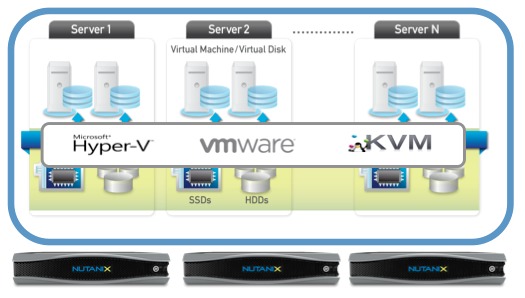

Le principal challenge de cette mise en place est d’arriver à établir un mode de gestion des ressources, qui puisse faciliter le passage d’un environnement virtuel dit « traditionnel », comme VMware, HyperV ou autre hyperviseur du marché à un mode complètement consolidé du côté matériel. Le passage de machines virtuelles quel que soit l’hyperviseur n’aura plus d’importance par la suite et pourra se faire sans se soucier de problèmes de performances ou d’éventuelle compatibilité.

Du hardware…mais pas que !

La plupart des acteurs de ce nouveau mode de travail proposent des solutions avec des appliances physiques, c’est-à-dire des solutions matérielles où tout est embarqué dedans (CPU, stockage flash SSD, réseau). Le principe est de consolider sur une seule pile logicielle tous les composants, dans une démarche « software defined ». Mais il est également possible de faire cette approche avec du hardware existant, en revoyant le mode d’administration (exemple avec Nutanix et son système Prism). Explications en vidéo (en anglais):

Virtualiser..la virtualisation !

Cela peut paraître un peu pompeux, mais oui, on peut poser plusieurs hyperviseurs dans ce genre d’appliances, réduisant du coup le besoin d’avoir une Hardware Compatiblity List (HCL) pour le datacenter. Le principal avantage reste de réduire le nombre de serveurs physiques et la dépendance à un système central de stockage (hormis la partie serveur de fichiers qui n’a pas forcément besoin de système SAN coûteux). D’ailleurs, une approche de hyperconvergence est virtualiser les sources de stockage pour le représenter par le réseau avec une classification de la qualité du stockage, selon les besoins applicatifs (un exemple est l’approche proposée par DataCore). Pour comprendre le modèle de Datacore, petite explication en vidéo (en anglais):

En résumé…

L’hyperconvergence est une évolution de l’approche de la virtualisation des ressources dans un datacenter, à l’instar de ce que proposent les grands noms actuels, tels que VMware, Microsoft ou Citrix. A terme, cette approche va être reprise par les constructeurs de hardware pour devenir une solution facilitant la consolidation de ressources, l’uniformisation et l’automation des environnements datacenters, essentiellement pour rapidement provisionner des machines virtuelles, avec une orientation pour le Cloud computing. Pour ceux qui se demandent comment aller dans l’hyperconvergence ou qui auraient besoin de compléments, une (bonne) base de départ: http://www.hyperconverged.org (site en anglais). Le seul point négatif reste pour ceux qui ont déjà des infrastructures les coûts assez élevés des solutions et la préparation d’une migration, ainsi qu’un nouvel apprentissage de produit.