Interactivité Homme-machine: les solutions

Depuis toujours, l’homme a voulu améliorer son interactivité avec les machines. Depuis le début de l’informatique, les concepts de contrôle par la voix ou par le toucher ont été légions mais seulement depuis peu, ces moyens font partie de la réalité. Nous allons aborder quels sont ces technologies et comment elles se trouvent au quotidien, avec un tour d’horizon sur les technologies d’hier, d’aujourd’hui….et de demain.

Pas touche à mon écran !!!

On le sait, avec les tablettes et les smartphones, le tout tactile a été depuis 2007 un élément qui a envahi notre quotidien. Les ordinateurs avec une surface tactile existent depuis plus longtemps mais cet interface a commencé son essor depuis peu.

L’emploi de gants dans le domaine de la réalité virtuelle, avait permis en son temps de rendre la notion du toucher dans une sphère d’activités spécifique quelque chose de…palpable !

Cette notion d’interactivité a permis de créer d’autres débouchés, sans pour autant avoir besoin d’un équipement trop conséquent, comme c’était le cas avec les environnement de projection 3D, des casques avec des écrans stéréoscopiques embarqués ou ces fameux gants qui restituent la sensation de tenir un objet, en modifiant la résistance sur les axes vers les doigts.

Aujourd’hui, le fait d’effleurer un écran, au lieu d’utiliser une souris est devenu chose normale, voir banale. Mais au-delà de cet avantage, les appareils futurs ne devront plus nécessairement être tactiles, comme le démontre déjà certains développements de périphériques. On parle volontiers d’environnement holographique ou semi-projetés, en employant des surfaces réfléchissantes et des capteurs de mouvements.

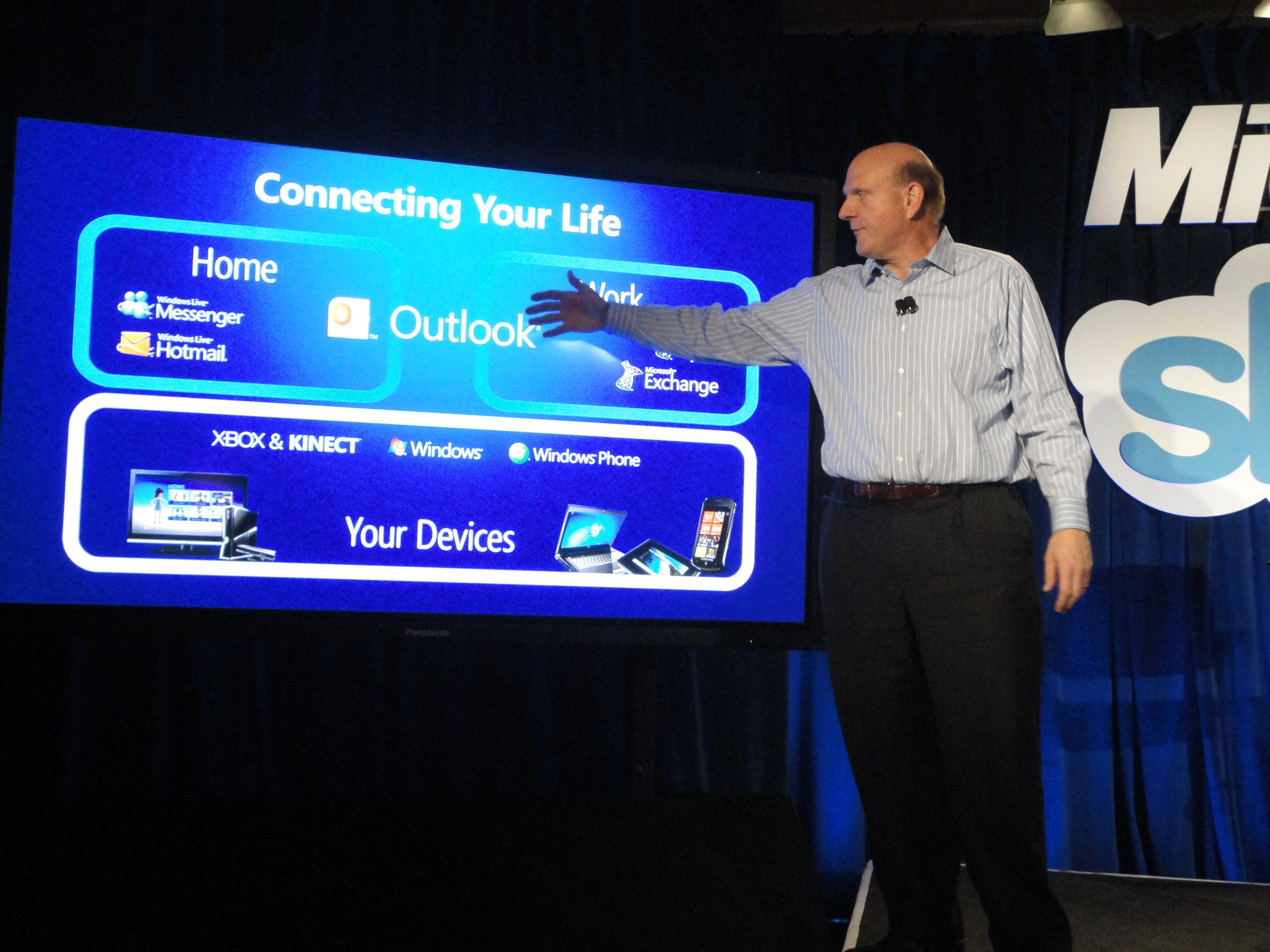

Ce genre de procédé a notamment inspiré Microsoft, avec leur produit Kinect, qui d’abord dans le domaine ludique a fait une percée mais aujourd’hui, on peut le trouver dans d’autres secteurs d’activités.

Au doigt, mais aussi à l’oeil !

Plus récemment, certains brevets ont été mis en pratique, plus spécifiquement dans ce que l’on appelle le Eye Tracking (suivi du regard littéralement), et Samsung a dévoilé avec son Galaxy S4, une première implémentation dans le secteurs des mobiles.

Le concept a été porté par une firme du nom de eMoove, repris par Samsung. Bien évidemment, d’autres vont se pencher sur les possibilités de ce développement et nous devrions voir cette fonction de Eye Tracking arriver dans d’autres périphériques. Et dans le domaine des périphériques qui s’attachent à interagir avec notre vision, impossible de passer à côté de l’annonce que Google a faite concernant leur produit Glass.

D’ores et déjà prévu pour fonctionner sur plusieurs plate-formes mobiles, nul doute que ce type d’interaction sera encore immersive que ce que l’on a connu jusque là. Reste que l’aspect donne un air de robot et qu’il faudra voir si tout le monde suivra car il s’agit clairement d’un changement dans les habitudes des utilisateurs.

Revenons à un usage sur ordinateurs, car là également, les périphériques n’ont guère évolué. En dehors d’une banalisation par Apple sur les TouchPad (on se souvient du Magic TrackPad), rien de nouveau ne s’était profilé à l’horizon.

Ceci pourrait changer très prochainement avec la sortie du Leap Motion, petit rappel sur cet article. J’attends de le recevoir et je reviendrai avec un article sur ce périphérique.

Et pour terminer, impossible de parler d’interactivité sans parler du contrôle vocal. De ce côté, Apple a lancé un pavé dans la mare avec son assistant Siri. Histoire de voir comment rendre cet assistant personnel plus “intelligent”, voici quelques vidéos, assez sympas:

et une 2ème:

Il est très probable que Apple fournisse sur une version future de OSX un contrôle vocal du même genre, ce qui devrait changer notre interaction avec les Macs (oui sur Windows il y a aussi un système de dictée vocale et ce depuis Vista). Voici une petite vidéo sur Windows RT et la reconnaissance vocale (on ne rit pas !):

et pour OSX Mountain Lion (en anglais):

Wait & See…